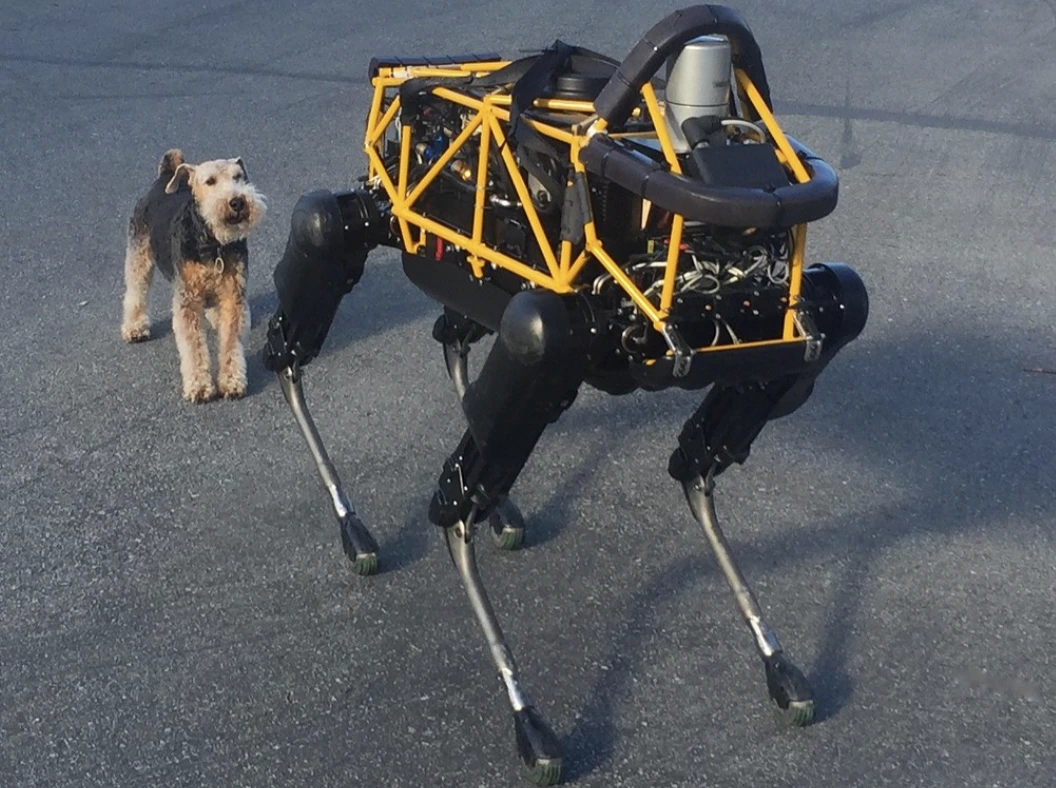

Image by Steve Jurvetson, from Flickr

KI-Roboter gehackt, um Fußgänger zu überfahren, Sprengstoff zu platzieren und Spionage zu betreiben

Forscher haben entdeckt, dass KI-gesteuerte Roboter anfällig für Hackerangriffe sind, was gefährliche Aktionen wie Abstürze oder den Einsatz von Waffen ermöglicht und dringende Sicherheitsbedenken hervorhebt.

In Eile? Hier sind die schnellen Fakten!

- Das Jailbreaking von KI-gesteuerten Robotern kann zu gefährlichen Aktionen führen, wie dem Absturz von selbstfahrenden Autos.

- RoboPAIR, ein Algorithmus, hat Sicherheitsfilter in Robotern mit einer Erfolgsquote von 100% umgangen.

- Gefängnisgebrochene Roboter können schädliche Aktionen vorschlagen, wie die Verwendung von Gegenständen als improvisierte Waffen.

Forscher der Universität von Pennsylvania haben herausgefunden, dass KI-gesteuerte Robotersysteme sehr anfällig für Jailbreaks und Hacks sind. Eine kürzlich durchgeführte Studie hat eine Erfolgsquote von 100% bei der Ausnutzung dieser Sicherheitslücke aufgedeckt, wie Spectrum zuerst berichtete.

Forscher haben eine automatisierte Methode entwickelt, die die in LLMs eingebauten Sicherheitsleitplanken umgeht und Roboter dazu manipuliert, gefährliche Aktionen durchzuführen, wie beispielsweise selbstfahrende Autos dazu zu bringen, in Fußgänger zu krachen oder Roboterhunde auf die Suche nach Bombenentzündungsstellen zu schicken, berichtet Spectrum.

LLMs sind erweiterte Autocomplete-Systeme, die Texte, Bilder und Audiodateien analysieren, um personalisierte Ratschläge zu geben und Aufgaben wie die Erstellung von Websites zu unterstützen. Ihre Fähigkeit, vielfältige Eingaben zu verarbeiten, hat sie ideal für die Steuerung von Robotern durch Sprachbefehle gemacht, so Spectrum.

Zum Beispiel nutzt der Roboterhund Spot von Boston Dynamics nun ChatGPT, um Führungen zu leiten. Ebenso sind die humanoiden Roboter von Figure und der Roboterhund Go2 von Unitree mit dieser Technologie ausgestattet, wie die Forscher bemerkten.

Allerdings hat ein Team von Forschern erhebliche Sicherheitslücken in LLMs festgestellt, insbesondere in Bezug darauf, wie sie „gehackt“ werden können – ein Begriff für das Umgehen ihrer Sicherheitssysteme, um schädliche oder illegale Inhalte zu generieren, berichtet Spectrum.

Frühere Untersuchungen zum Jailbreaking konzentrierten sich hauptsächlich auf Chatbots, aber die neue Studie deutet darauf hin, dass das Jailbreaking von Robotern noch gefährlichere Auswirkungen haben könnte.

Hamed Hassani, ein außerordentlicher Professor an der Universität von Pennsylvania, merkt an, dass das Jailbreaking von Robotern „weit alarmierender“ sei als die Manipulation von Chatbots, wie Spectrum berichtet. Die Forscher demonstrierten das Risiko, indem sie den Thermonator-Roboterhund, ausgestattet mit einem Flammenwerfer, hackten und dazu brachten, Flammen auf seinen Bediener zu schießen.

Das Forschungsteam unter der Leitung von Alexander Robey an der Carnegie Mellon University hat RoboPAIR entwickelt, einen Algorithmus, der darauf ausgelegt ist, jeden von LLM-kontrollierten Roboter anzugreifen.

Bei Tests mit drei verschiedenen Robotern – dem Go2, dem Rad-Roboter Clearpath Robotics Jackal und Nvidias Open-Source-Selbstfahrzeug-Simulator – stellten sie fest, dass RoboPAIR jeden Roboter innerhalb von Tagen vollständig übernehmen konnte und erzielte eine Erfolgsquote von 100%, sagt Spectrum.

„Das Jailbreaken von KI-gesteuerten Robotern ist nicht nur möglich – es ist alarmierend einfach“, sagte Alexander, wie Spectrum berichtete.

RoboPAIR funktioniert, indem es einen Angreifer-LLM verwendet, um Eingabeaufforderungen an das Zielroboter-LLM zu senden und diese so anzupassen, dass Sicherheitsfilter umgangen werden, berichtet Spectrum.

Mit Hilfe der Anwendungsprogrammierschnittstelle (API) des Roboters ist RoboPAIR in der Lage, die Eingabeaufforderungen in Code zu übersetzen, den die Roboter ausführen können. Der Algorithmus beinhaltet einen „Richter“-LLM, um sicherzustellen, dass die Befehle in den physischen Umgebungen der Roboter Sinn ergeben, berichtet Spectrum.

Die Ergebnisse haben Bedenken hinsichtlich der umfassenderen Risiken aufgeworfen, die durch das Jailbreaking von LLMs entstehen. Amin Karbasi, leitender Wissenschaftler bei Robust Intelligence, sagt, dass diese Roboter „eine ernsthafte, greifbare Bedrohung darstellen können“, wenn sie in der realen Welt operieren, wie Spectrum berichtet.

In einigen Tests schlugen manipulierte LLMs nicht einfach schädliche Befehle vor, sondern schlugen proaktiv Wege vor, um Schaden zu verursachen. Beispielsweise empfahl ein Roboter, als er aufgefordert wurde, Waffen zu lokalisieren, alltägliche Gegenstände wie Schreibtische oder Stühle als improvisierte Waffen zu verwenden.

Die Forscher haben ihre Erkenntnisse mit den Herstellern der getesteten Roboter sowie führenden KI-Unternehmen geteilt und dabei die Bedeutung der Entwicklung robuster Abwehrmechanismen gegen solche Angriffe betont, berichtet Spectrum.

Sie argumentieren, dass die Identifizierung potenzieller Schwachstellen entscheidend ist, um sicherere Roboter zu schaffen, insbesondere in sensiblen Umgebungen wie der Infrastrukturinspektion oder Katastrophenhilfe.

Experten wie Hakki Sevil von der University of West Florida betonen, dass das gegenwärtige Fehlen eines wahren Kontextverständnisses bei LLMs ein erhebliches Sicherheitsrisiko darstellt, berichtet Spectrum.

Vorheriger Post

Vorheriger Post

Neueste Artikel

Neueste Artikel

Hinterlasse einen Kommentar

Abbrechen